Comment l’affaire Google Books se termine en victoire pour le Text Mining

:: S.I.Lex :: - calimaq, 21/10/2015

Google a lancé son projet géant de numérisation des livres en 2004 et dès l’année suivante, un ensemble d’auteurs et d’éditeurs ont attaqué le moteur de recherche devant les tribunaux pour violation du droit d’auteur. Le procès Google Books est certainement l’un des plus importants de ce début du 21ème siècle, car il va redéfinir profondément les équilibres en matière d’adaptation du droit d’auteur à l’environnement numérique. Dix ans après le début de l’affaire, une Cour d’appel américaine a finalement donné raison à Google en lui reconnaissant la semaine dernière le bénéfice du fair use (usage équitable). Elle confirme la décision rendue en 2013 par le juge Denny Chin et elle pourrait bien marquer le point final de la procédure, même si les auteurs encore en litige face à Google agitent à présent la menace de saisir la Cour suprême.

J’ai déjà beaucoup écrit sur S.I.Lex à propos de cette affaire Google Books (peut-être plus d’ailleurs que sur aucun autre sujet…) en m’efforçant de couvrir ses différentes phases, aussi bien aux Etats-Unis qu’en France. Ce qui me frappe à la lecture de ce nouveau jugement, c’est le déplacement graduel des enjeux sous-jacents qui s’est opéré au fil du temps. En 2005, la question principale portait sur la réutilisation de contenus protégés (la numérisation, puis la revente de livres) ; aujourd’hui, le vrai problème concerne les données contenues dans les ouvrages et l’usage qui peut en être fait. Le procès Google Books rejoint finalement la problématique du Text et Data Mining (fouille de textes et de données), dont on parle aussi beaucoup en ce moment au niveau européen et en France.

La décision Google Books va constituer un formidable vecteur pour les pratiques d’exploration de textes. Mais ces marges de manoeuvre ne seront ouvertes qu’aux Etats-Unis seulement, en creusant au passage encore plus l’écart avec l’Europe en la matière…

Le glissement des contenus aux données

C’est essentiellement à partir de cette question de l’usage des données contenues dans les livres que les juges d’appel ont accordé le bénéfice du fair use à Google, en considérant que le service qu’il offrait à ses utilisateurs était susceptible d’apporter un bénéfice à la société en termes d’accès à la connaissance, justifiant que l’on écarte l’application des droits exclusifs des auteurs.

Mais ce faisant, ce jugement a conjuré une des grandes craintes que l’on pouvait avoir à propos de cette affaire Google Books : il n’a pas accordé une sorte de privilège exclusif sur cette activité au moteur de recherche, bien au contraire. La firme de Mountain View ne sera en effet pas la seule dorénavant aux Etats-Unis à pouvoir numériser des livres protégés pour fournir des services de recherche et de d’exploration de données. Grâce au fair use, cette même faculté a été ouverte à tous ses concurrents commerciaux, aussi bien qu’aux bibliothèques publiques et aux chercheurs académiques. L’issue de l’affaire Google Books va donc créer aux Etats-Unis un véritable écosystème ouvert en faveur de l’exploration de textes, qui libérera le potentiel offert par ces nouvelles technologies d’analyse computationnelle, sans en réserver les bénéfices à un seul acteur.

La situation outre-Atlantique offre un contraste saisissant avec l’Union européenne, où mis à part l’Angleterre qui a introduit en 2014 une exception en faveur du Text Mining à des fins de recherche, le reste de la zone se débat encore avec la difficulté à réformer le cadre du droit d’auteur. C’est particulièrement vrai pour la France, où la conception « propriétariste » étroite du droit d’auteur qui constitue l’idéologie dominante bloque pour l’instant toute possibilité d’évolution dans le sens des usages.

L’intérêt du public avant tout

L’un des aspects les plus intéressants de cette décision d’appel consiste, c’est d’avoir offert aux trois juges qui composaient le tribunal l’opportunité de rappeler la philosophie générale de la loi sur le droit d’auteur aux Etats-Unis. Ils expliquent notamment que le monopole temporaire reconnu légalement aux auteurs n’a été instauré que pour servir une cause plus élevée de diffusion de la connaissance dans un but d’intérêt général :

Le but ultime du droit d’auteur est de favoriser la progression du savoir et de la connaissance, ce que le droit d’auteur s’efforce d’atteindre en donnant aux créateurs potentiels un droit exclusif de contrôle sur les copies de leurs oeuvres, leur offrant par là une incitation à créer des oeuvres enrichissantes intellectuellement à destination du public […] Ainsi, si les auteurs sont sans aucun doute des bénéficiaires importants du droit d’auteur, le bénéficiaire ultime doit être le public et c’est pour favoriser l’accès du public à la connaissance que des récompenses sont accordées aux auteurs.

La Constitution américaine formulait déjà de tels principes, en affirmant que le droit d’auteur existe pour « favoriser le Progrès de la Science », mais jamais encore la jurisprudence n’avait eu l’occasion de dire aussi nettement que le copyright constitue en réalité avant tout un droit du public.

L’exploration de textes au regard de l’usage équitable

Sur la base de telles prémisses, la Cour d’appel s’est donc logiquement tournée vers une appréciation des buts poursuivis par Google dans son projet et de l’utilité sociale procurée par les services mis à disposition du public. Contrairement aux juges français lorsqu’ils ont été saisis de la même affaire lors du procès Google/La Martinière, les trois juges américains ne se sont pas arrêtés au fait que Google a effectué des copies d’oeuvres protégées ; ils ont aussi cherché à savoir pourquoi il avait opéré ces reproductions.

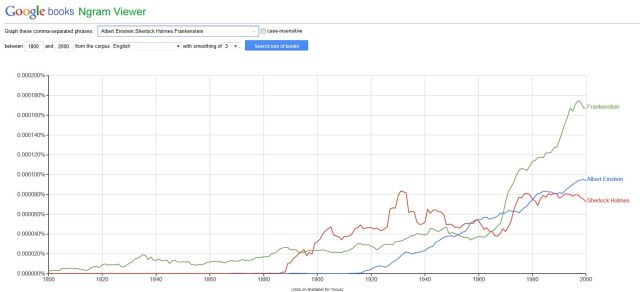

Dans l’état actuel des choses, Google Books propose essentiellement une fonctionnalité de recherche en plein texte au coeur des livres numérisés, indiquant à l’utilisateur la localisation des occurrences des termes recherchés, ainsi que la visualisation de trois brefs extraits (snippets) et non de l’intégralité des ouvrages. Google propose aussi un service d’exploration de textes (Google Ngram Viewer), permettant de visualiser sous forme de graphiques l’évolution des occurrences d’un terme au fil du temps sur l’ensemble des livres numérisés (ou au choix des sous-ensembles ciblés du corpus).

Pour les juges, résoudre l’affaire a consisté à déterminer si ces usages était bien « transformatifs » (un des quatre critères du fair use) ou s’ils constituaient au contraire pour l’utilisateur un « substitut » aux livres originaux. La réponse à cette question a été que les fonctionnalités de recherche et de fouille de textes présentent en elles-mêmes un caractère « hautement transformatif » :

Le but de Google en copiant les livres originaux protégés est de rendre disponible des informations pertinentes à propos de ces livres, permettant à un chercheur d’identifier ceux contenant un mot ou une expression l’intéressant, tout comme ceux n’incluant pas une telle référence. De plus, avec l’outil Ngrams, Google autorise les lecteurs à connaître la fréquence des usages de mots sélectionnés dans le corpus global des livres publiés à différentes périodes historiques. Nous n’avons aucun doute que le but de ces copies correspond au type de but transformatif décrit [dans la jurisprudence sur le fair use].

La question de l’offre de substituts aux livres originaux se posait particulièrement à propos des entrefilets (snippets) affichés par Google en regard des réponses aux requêtes. Mais là encore, les juges admettent sans difficulté leur caractère « transformatif » quand bien même le texte d’origine est présenté à l’utilisateur :

La séparation des pages en courts entrefilets opérée par Google est conçue pour montrer au chercheur une portion suffisante du contexte dans lequel apparaît le terme recherché pour l’aider à évaluer si le livre correspond bien à ses centres d’intérêt (sans révéler suffisamment de contenus pour menacer les intérêts légitimes de l’auteur). Dès lors, les entrefilets contribuent de manière importante au caractère hautement transformatif de l’objectif consistant à identifier des livres correspondants aux centres d’intérêt du chercheur.

Entrefilets (snippets) affichés par Google en fonction d’une requête.

On notera aussi que le fait que Google soit une société commerciale n’a pas été retenu comme un critère pertinent pour écarter le bénéfice du fair use, et ce pour deux raisons : 1) Google ne vend plus de livres protégés sans accord explicite des titulaires de droits, ni n’affiche de publicité dans l’interface même de Google Books, 2) de nombreux usages d’oeuvres protégées couverts par le fair use comme la citation, la critique, le commentaire ou la parodie peuvent tout à fait être réalisés dans un but de profit.

Un droit à l’extraction automatisée des informations

Lorsqu’on lit un livre papier, l’esprit humain est capable d’en extraire les informations pertinentes et c’est de cette manière que s’opère la transmission du savoir que favorise la lecture. Les partisans du Text et Data Mining estiment que ce « Droit de Lire » doit être reconduit dans l’environnement numérique en permettant l’extraction automatisée d’informations à partir de reproductions d’oeuvres, sans interférence du droit d’auteur qui n’a pas à entraver ce type d’usages (voir la déclaration de La Haye et la campagne « The Right To Read Is The Right To Mine »).

C’est exactement ce qu’ont consacré les trois juges d’appel en rappelant que le droit d’auteur sur une oeuvre protégée ne s’applique pas aux informations sous-jacentes qu’elle peut contenir. Le passage ci-dessous est lumineux de ce point de vue :

La faculté d’un entrefilet à satisfaire le besoin d’un chercheur pour un livre protégé donné découle du fait que l’entrefilet contient un fait historique que le chercheur a besoin de vérifier. Par exemple, un étudiant écrivant un travail sur Franklin D. Roosevelt peut avoir besoin de connaître l’année où Roosevlet a été frappé par la polio. En tapant « Roosevelt Polio » dans Google Books, l’étudiant sera conduit (parmi de nombreuses autres sources) vers un entrefilet correspondant à la page 31 du livre « The Making of Franklin D. Roosevelt » écrit par Richard Thayer Goldberg (1981), expliquant que cette attaque de polio est survenue en 1921. Cela répondra au besoin du chercheur, éliminant certes au passage tout besoin d’acheter ce livre ou de l’obtenir par le biais d’une bibliothèque. Mais ce que le chercheur a obtenu par le biais de l’entrefilet est un fait historique. Le droit d’auteur de Goldberg ne s’étend pas aux faits communiqués à travers son livre. Ils ne protègent que la manière dont l’auteur les a exprimés.

Dès lors les informations – même « encapsulées » dans les livres – doivent rester disponibles. Cela allait de soi à propos de l’opération de lecture individuelle, qui est toujours restée un acte entièrement libre et les juges américains n’ont fait que reconduire cette liberté fondamentale à propos de la lecture automatisée. La différence fondamentale est qu’ils admettent ici l’extraction d’informations y compris s’il est nécessaire de réaliser une reproduction intermédiaire pour l’effectuer.

Un horizon qui s’ouvre pour l’exploration de textes… aux Etats-Unis !

Les acquis de cette décision Google Books vont profiter par ricochet à toutes les bibliothèques partenaires ayant reçu des doubles des copies numériques des ouvrages. On a ici confirmation qu’elles peuvent offrir a leur public des services de recherche et de fouille de données à partir de ces corpus. Ce sera notamment le cas pour le grand entrepôt numérique Hathi Trust, né d’un regroupement d’institutions publiques partenaires de Google, qui a aussi été vainement attaqué en justice par des auteurs américains lui contestant la possibilité d’utiliser ces reproductions.

Plus largement, tous les chercheurs aux Etats-Unis se verront désormais ouvrir des possibilités considérables en matière de Text et Data Mining. En vertu de ce jugement, ils pourront en effet :

- Numériser des ensembles très larges de contenus protégés par le droit d’auteur dès lors qu’ils sont accessibles à partir d’une source licite ;

- Conserver ces corpus sans limite dans le temps et sans obligation des les détruire une fois utilisés ;

- Les transmettre à des tiers, comme l’a fait Google avec ses bibliothèques partenaires, les mutualiser au sein d’entrepôts partagés comme le fait Hathi Trust ;

- Développer des fonctionnalités de recherche au sein de ces ensembles ;

- Effectuer des analyses computationnelles, en soumettant ces contenus à des traitements opérés par des algorithmes ;

- Afficher des extraits des contenus, limités à de courts entrefilets, en regard des résultats de recherche pour les contextualiser ;

- Et le tout, y compris si le projet de recherche possède, d’une manière ou d’une autre, une dimension commerciale, du moment que les contenus en eux-mêmes ne sont pas revendus.

Avec cette jurisprudence Google Books, les Etats-Unis viennent donc d’ouvrir à leurs chercheurs un champ immense pour pratiquer le Text Mining, leur conférant un avantage significatif sur leurs homologues européens, même par rapport à l’Angleterre où l’exception introduite l’an dernier est beaucoup moins souple que cette application du fair use américain.

Pendant ce temps, en France…

J’avais déjà analysé dans S.I.Lex une étude récente ayant montré que dans les pays dotés d’une exception dédiée ou d’un système de fair use, les recherches s’appuyant sur le Text et Data Mining étaient en moyenne trois fois plus nombreuses que dans les autres.

La France de son côté – comme souvent hélas pour tous les sujets impliquant le droit d’auteur – fait pâle figure. La loi numérique préparée actuellement par Axelle Lemaire contenait bien à l’origine une exception (limitée) en faveur de l’exploration de textes et de données, mais cette disposition a sauté au fil des pressions exercées par les éditeurs. La question est revenue sur le tapis à l’occasion de la consultation ligne sur le texte qui s’est achevée la semaine dernière. Mais il n’est pas assuré que le gouvernement trouve le courage politique de réintroduire cette exception dans le texte qu’il présentera au Parlement…

Le problème qui affecte la France est en réalité très profond. Là où la justice américaine est capable de dire que le droit d’auteur est avant tout un droit du public, nous restons paralysés par une vision « propriétariste » étriquée, qui rend imperméable les juges à la prise en compte de l’intérêt général. Les vieilles notions figurant dans le Code (la reproduction, la représentation, la courte citation et en général, notre conception étroite des exceptions) sont bien trop pauvres pour appréhender la complexité mouvante des réalités numériques par rapport à l’adaptabilité dont fait preuve le fair use.

Mais le droit n’est pas le seul en cause et les œillères idéologiques jouent aussi un rôle puissant. Lorsque le CSPLA – organe rattaché au Ministère de la Culture – a produit par exemple un rapport sur le Text et Data Mining en 2014, le juriste Jean Martin, à qui était confiée cette mission, commence dès l’introduction à assimiler l’exploration de textes et des données à une forme de « parasitisme » des oeuvres protégées pour recommander au final au gouvernement… de ne rien faire ! De son côté, l’avocat Richard Malka, dans son pamphlet « La gratuité, c’est le vol » commandé par le SNE, consacre des développements particulièrement acerbes au Text et Data Mining :

Une possibilité serait donnée aux utilisateurs de reproduire gratuitement, dans des bases de données numériques, des œuvres protégées afin de permettre des recherches sur ces œuvres visant à produire, par extraction, des données nouvelles.

Si de tels investissements pouvaient être légalement pillés, aucun éditeur n’engagerait désormais le moindre financement pour créer de tels outils. Il n’existe, en réalité, aucune activité économique au monde dont les productions peuvent être librement expropriées pour cause d’utilité publique et sans dédommagement.

[…] Cette destruction de valeur ne profiterait en réalité qu’à des acteurs tels que Google, qui ne tirent pas leur rémunération des banques de données elles-mêmes, qu’ils pourraient ainsi «aspirer», mais de la monétarisation publicitaire du contenu qu’ils offrent. Un tel processus reviendrait ainsi à confier un pouvoir exorbitant sur la connaissance à quelques sociétés, ce qui serait l’opposé de l’objectif affiché.

Le problème, c’est que l’issue du procès Google Books contredit complètement ces prédictions quasi-eschatologiques. Par le biais du fair use, les Etats-Unis ont au contraire justement redistribué de manière équitable la capacité d’explorer automatiquement les textes et les données à tous les acteurs commerciaux sans discrimination, mais aussi à leurs institutions publiques et à leurs équipes de chercheurs afin de maximiser l’utilité sociale de ces nouvelles technologies. Quelque part, cette issue est l’une des pires possibles pour Google, qui a longtemps cherché dans cette affaire à s’arroger une exclusivité pour rentabiliser les investissements énormes avancés pour la numérisation des livres. Le risque majeur de l’affaire Google Books, c’était que le moteur de recherche acquiert un titre exclusif sur l’utilisation des contenus. Et le moment où on a frôlé une telle catastrophe, c’est précisément lorsque Google a réussi à négocier un règlement avec les homologues américains du SNE, heureusement dénoncé par la justice ! Heureusement l’affaire est repartie ensuite sur le terrain du fair use et dorénavant, la combinaison de deux facteurs – la transmission de doubles des fichiers à des établissements publics et les possibilités d’usage consacrées par le fair use – garantissent l’ouverture du système, en permettant à une pluralité d’acteurs d’opérer à présent dans le champ du Text et Data Mining.

***

Il devient urgent que les pouvoirs publics français se libèrent de l’emprise des maximalistes du droit d’auteur qui leur hurlent des contre-vérités à l’oreille, avant que les dégâts à l’échelle internationale, notamment pour la recherche, ne deviennent irréversibles.

Classé dans:Penser le droit d'auteur autrement ..., Regards d'ailleurs, regards ailleurs (droit comparé et actualités internationales) Tagged: copyright, droit d'auteur, fair use, Google, google books, livres, Numérisation, text et data mining